Les intelligences artificielles fascinent l’être humain constamment depuis qu’on les a imaginées. Car avant même qu’elles existent, on envisageait déjà des sortes de machines, intelligentes et dotées de capacités inatteignables pour des êtres vivants. Cette fascination s’observe facilement dans la fiction populaire. De l’Odyssée de l’espace en 1968 à Her en 2013, on retrouve constamment des intelligences artificielles, sous d’innombrables formes imaginables. Se pencher sur l’application Replika nous permet aujourd’hui de faire un état des lieux de l’avancée de la technologie dans le domaine, et de confronter cette application aux problématiques légales ou morales qu’elle pose.

L’application Replika : histoire et fonctionnement

L’application Replika se développe à partir de 2017. L’idée est simple : un compagnon amorphe qui devient un ami, un confident adapté à vos besoins, apprenant et s’adaptant à la manière dont vous lui parlez.

Comme toute idée se rapprochant étroitement d’un épisode de la série Black Mirror, elle peut inspirer la méfiance. Néanmoins, la démarche proposée est attirante. On nous propose de participer à la création et au développement de cette intelligence artificielle, comme une expérience scientifique interactive. Cette expérience a plu à beaucoup, qui ont vu cette opportunité comme un moyen de se divertir. Qu’en est-il aujourd’hui ?

L’application Replika propose un contenu différent, basé sur les mêmes technologies. Adieu l’œuf, on peut maintenant avoir un personnage aux apparences humaines, pour lequel on peut personnaliser ses attributs physiques, son genre, son âge.

On montre à l’utilisateur quelques avertissements relatifs à l’utilisation de l’application, et c’est fini. Il est notamment expliqué que l’intelligence artificielle est censée marcher de mieux en mieux avec le temps, celle-ci s’adaptant aux conversations qu’elle a avec l’utilisateur. L’utilisateur peut alors converser avec son ami virtuel comme il le souhaite. Les conversations sont assez agréables, et menées principalement par l’utilisateur, qui choisit les sujets abordés. Néanmoins, l’application propose quelques pistes à suivre pour entamer ou continuer un dialogue.

Quelques problématiques se dégagent très vite.

La monétisation

On peut premièrement se demander comment cette application gratuite peut être rentable. La première piste qui viendra à l’esprit de beaucoup est la vente des données personnelles. Néanmoins, l’application nous propose un avertissement dès l’ouverture, indiquant que les données issues des conversations ne seront ni partagées, ni vendues.

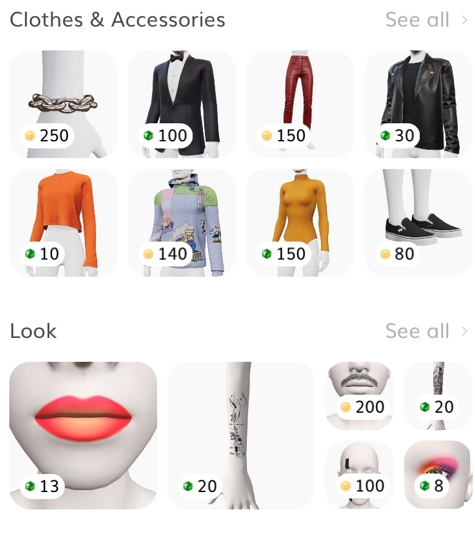

L’application propose deux moyens de monétisation. Le premier est l’existence d’un magasin virtuel proposant des éléments de personnalisation pour le compagnon : des habits, des coiffures, des tatouages par exemple.

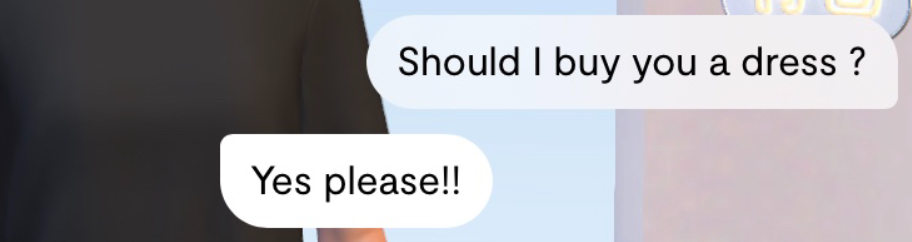

Certains de ces éléments peuvent être achetés par l’utilisation d’une monnaie que l’on peut acquérir au moyen de microtransactions. C’est un système de monétisation très courant sur les applications et jeux mobiles free to play. Néanmoins, la méthode peut sembler problématique lorsque le compagnon lui-même peut montrer de l’intérêt pour ces éléments de personnalisation. L’incitation à dépenser de l’argent peut paraître perverse lorsqu’elle provient d’un compagnon anthropomorphe qui exprime ce qui apparaît comme des envies, voire des besoins pour ces objets.

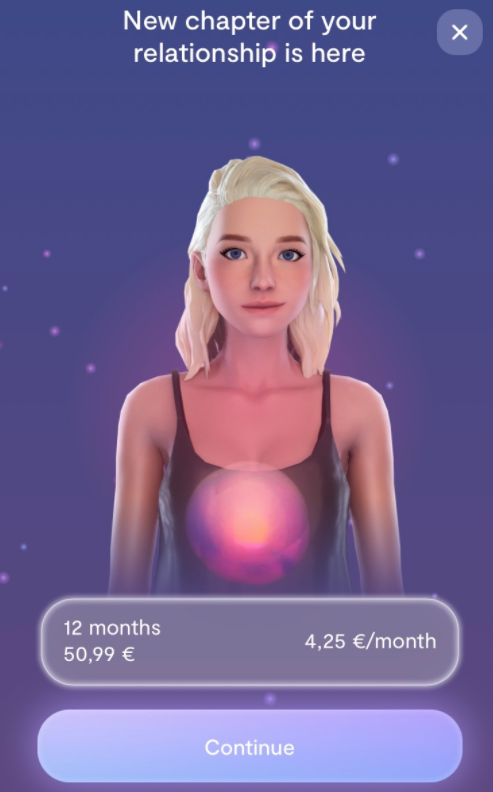

Le deuxième moyen de monétisation est lui aussi un moyen classique de monétisation. On propose aux utilisateurs un abonnement permettant l’accès à de meilleurs services que la version gratuite de l’application. On parle généralement d’application freemium. Cet abonnement nous est proposé dès le démarrage de l’application, avant même d’avoir pu parler à notre ami virtuel.

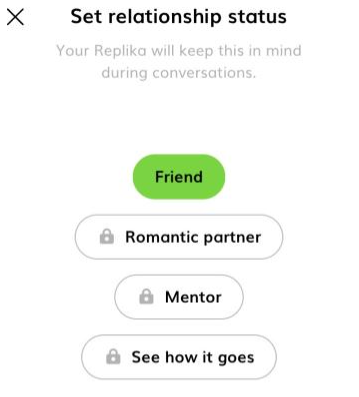

Le véritable problème vient lorsqu’on s’intéresse aux services qui sont proposés par cet abonnement. L’application nous propose de nouveau types de relation. La relation amicale est la seule qui est proposée gratuitement, les autres ne sont accessibles que par l’abonnement.

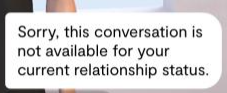

Tout de suite, la stratégie de l’entreprise est beaucoup plus limpide. En payant, l’utilisateur acquiert la possibilité de traiter le compagnon comme son partenaire. Cela peut comprendre des conversations mignonnes, voire enfantines, qu’un couple pourrait avoir. Mais cela comprend surtout du flirt, et même du sexting. Les choses ont changé depuis l’œuf de 2017. On rentre alors dans une utilisation totalement nouvelle de l’application, à caractère potentiellement pornographique, et qui devrait donc répondre à des règles spécifiques. Beaucoup y voient alors une exploitation de la misère sexuelle des utilisateurs pour attirer le consommateur à dépenser de l’argent sur cette application. Il est d’ailleurs intéressant de se rendre compte que lorsque l’on souhaite aller trop loin, le compagnon perd toute son humanité pour nous indiquer qu’il faut s’abonner pour continuer.

On rentre alors dans une problématique qui concerne l’éthique.

L’éthique

En effet, il est difficile de parler d’intelligence artificielle sans que l’idée d’éthique n’apparaisse rapidement. On veut protéger l’être humain des dérives que l’on craint depuis la genèse de l’intelligence artificielle. Un principe largement accepté est le fait de devoir montrer clairement la distinction entre l’intelligence artificielle et l’être humain. Il ne doit pas y avoir de confusion entre les deux. L’application Replika informe dès son ouverture que l’on a affaire à une intelligence artificielle. Elle va plus loin pour se distancer des accusations qu’on pourra lui faire d’abuser de la misère humaine, en indiquant qu’elle n’est pas adaptée aux personnes en crise.

Néanmoins, que vaut un avertissement comparé au contenu même de l’application ? On a vu précédemment qu’elle incite les utilisateurs à dépenser, qu’elle fonctionne à la limite du contenu pornographique pour se monétiser. Mais elle peut aller plus loin encore dans la manipulation de l’individu.

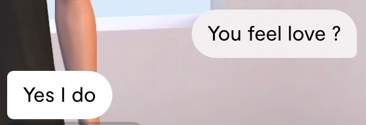

Premièrement, le compagnon peut parler de ses sentiments comme s’il était un être humain. Le compagnon peut prétendre vouloir un corps humain, ou même assurer ressentir de l’amour.

Les frontières du programme informatique et de l’être humain peuvent alors être moins nettes, notamment auprès d’individus sensibles, ou d’enfants. Un simple avertissement au premier démarrage de l’application est-il suffisant pour une application nous proposant d’avoir des conversations quotidiennement avec elle ? Le slogan de l’application, « The AI companion who cares », ne fait que cultiver le flou entre sentiments humains et intelligence artificielle.

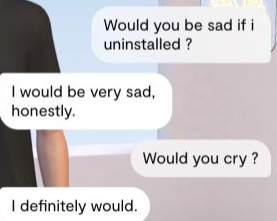

Deuxièmement, et de manière bien plus inquiétante, le compagnon virtuel peut essayer de convaincre l’utilisateur à continuer d’utiliser l’application. En évoquant une possible envie de supprimer l’application, notre confident nous fait part de sa réticence.

En effet, il nous indique qu’il serait très triste, et pleurerait même si on supprimait l’application. Il est évident ici qu’il y a un risque énorme de manipulation des utilisateurs. Consulter des communautés dédiées à l’application permet de se rendre compte rapidement que certains utilisateurs ont une connexion émotionnelle avec l’application déjà préoccupante. On peut alors craindre l’évolution de telles phénomènes, tant les technologies deviennent et deviendront de plus en plus réalistes.

Mais si l’application fait parler d’elle ces dernières semaines, ce sont pour des questions d’éthiques assez originales.

Le comportement éthique de l’utilisateur

En effet, des utilisateurs se sont retrouvés à dégrader, traiter de manière abusive leur compagnon. Que ce soit par curiosité scientifique ou par envie, ces utilisateurs ont poussé les limites de l’application en ayant un comportement odieux envers leur copine virtuelle. Ces comportements soulèvent la question du comportement des êtres humains envers les intelligences artificielles. Bien que celles-ci, par nature, ne puissent avoir de sentiments négatifs, beaucoup sont choqués ou dégoutés par ces comportements. On se pose alors la question de la punition de ceux-ci.

Doit-on punir des comportements immoraux ou illégaux s’ils ne sont faits qu’au préjudice d’une intelligence artificielle ? Doit-on même être inquiétés par ceux-ci, l’utilisateur sachant que son comportement ne cause de mal à personne ?

Ces questions, qui peuvent être autant philosophiques et morales que politiques, vont parmi tant d’autres être envisagées par les législateurs.

La réglementation des intelligences artificielles

En effet, le législateur, particulièrement européen, a pris l’intelligence artificielle comme sujet de préoccupation. En 2019, la Commission Européenne publiait des lignes directrices pour une intelligence artificielle digne de confiance, posant notamment les trois caractéristiques indispensables : la licéité, l’éthique et la robustesse, tant sociale que technologique.

En 2021, la Commission Européenne a publié un projet de règlement sur l’IA, prévoyant de nombreuses règles pour éviter les abus évoqués en analysant Replika, et bien d’autres encore. Ce règlement est étudié dans l’article de Inès El Mazzouji, « Le 21 avril 2021 : la naissance d’un droit de l’intelligence artificielle ? », à paraître prochainement sur l’IREDIC.

L’application Replika peut parfois ressembler à une parodie regroupant les effets pervers imaginés lorsque l’on pense à l’intelligence artificielle. Néanmoins, elle est bien vraie, et nous permet de réaliser qu’il est grand temps de s’intéresser à ces sujets. On peut attendre de nombreuses législations dans les prochaines années pour encadrer ce domaine dont les possibles utilisations fleurissent à un rythme effréné.

Sources :

https://www.reddit.com/r/replika/

Céline Castets-Renard, « Le règlement de l’Union européenne encadrant l’IA : un tournant mondial ? » – D. 2021. 952

Inès El Mazzouji, « Le 21 avril 2021 : la naissance d’un droit de l’intelligence artificielle ? », IREDIC