par Mathis LECLERC, étudiant du Master 2 Droit des médias électroniques

“Il s’agit là d’une réalisation historique et d’un pas-de-géant vers l’avenir ! L’accord conclu aujourd’hui répond efficacement à un défi mondial dans un environnement technologique en évolution rapide concernant un domaine clé pour l’avenir de nos sociétés et de nos économies. Et dans cette entreprise, nous sommes parvenus à maintenir un équilibre extrêmement délicat : encourager l’innovation et l’adoption de l’intelligence artificielle dans toute l’Europe tout en respectant pleinement les droits fondamentaux de nos citoyens.“

Carme Artigas Brugal, secrétaire d’État espagnole à la numérisation et à l’intelligence artificielle

Un accord politique provisoire entre les différents législateurs de l’Union européenne a été trouvé le 8 décembre 2023, afin de mettre en place la toute première législation encadrant spécifiquement les intelligences artificielles, l’AI Act (Artificial Intelligence Act).

Un compromis entre liberté d’innovation et respect des droits fondamentaux

Arriver à cet accord n’a pas été chose aisée. L’AI Act a fait l’objet de nombreux débats parlementaires, notamment car il mettait en confrontation deux visions distinctes de la manière dont devaient être encadrées les intelligences artificielles :

D’un côté, une vision libérale, celle des États membres comme la France ou l’Allemagne, qui prônent la mise en place d’un système d’autorégulation par les entreprises spécialisées dans l’IA. En clair, laisser les entreprises fixer leurs propres règles, afin de ne pas ralentir l’innovation de ce secteur d’activité et de permettre aux entreprises européennes de rester les plus compétitives possible. Si cette vision peut faire l’objet de nombreux débats, un point reste néanmoins légitime : imposer des règles, quelles qu’elles soient, reviendrait à délimiter le champ des possibles, et viendrait quoi qu’il arrive ralentir le développement de cette technologie et de ce marché aux lourds enjeux à la fois économiques et sociétaux. C’est la vision adoptée par Emmanuel Macron, qui estime que ce nouveau texte “n’est pas une bonne idée” en ce que de telles règles ne seront pas imposées à l’ensemble des acteurs mondiaux de l’IA.

D’un autre côté, une vision plus keynésienne, celle des députés européens qui prônent la mise en place d’une réglementation encadrant les intelligences artificielles, notamment afin de prévenir des dérives graves. Cette vision est alimentée par de nombreux exemples actuels démontrant les atteintes possibles à nos droits fondamentaux et à notre sécurité rendues possibles par les intelligences artificielles. En Chine par exemple, elles sont utilisées dans le cadre de la surveillance de masse et de la mise en place d’un “score social”, système attribuant à chaque citoyens une note qui fluctue en fonction de ses bonnes et mauvaises actions. Cette note sera ensuite utilisée pour délimiter les libertés de chaque individu : interdiction d’accès à certains services publics, aux transports ou encore aux logements sociaux.

Si l’on pourrait penser que ces dérives “n’ont lieu qu’ailleurs”, loin de l’Europe démocratique et soucieuse de la préservation des droits et libertés des citoyens, la réalité est complètement différente. En France, la Quadrature Du Net a révélé que la Caisse d’Allocations Familiales (CAF) utilisait déjà des algorithmes discriminatoires dans le cadre de la sélection des dossiers.

Un constat est donc simple : l’IA évolue déjà depuis plusieurs années sans règles spécifiques en Europe, et l’on constate peu à peu des utilisations attentatoires à nos droits les plus fondamentaux. L’intention des députés européens, celle de protéger les citoyens et la démocratie au travers d’une réglementation spécifique aux intelligences artificielles, semble plus que nécessaire face aux dimensions gargantuesques que prend cette technologie au sein de notre société.

Un compromis entre ces deux visions était donc plus que nécessaire. Oui, l’IA est un outil qui révolutionne notre société et il est plus que nécessaire de permettre l’innovation du secteur, mais il ne faut pas oublier l’essentiel : le respect de nos droits et de notre sécurité. C’était l’objectif de ce texte.

Comme le dira Thierry Breton, commissaire européen au marché intérieur, “Je pense que le texte que nous avons finalisé est une grande réussite car il trouve le point d’équilibre entre d’un côté la préservation de l’état de droit et des libertés fondamentales propres à nos démocraties, et, de l’autre, le développement de l’innovation. »

Un juste équilibre entre innovation et respect des droits fondamentaux au travers d’une réglementation en fonction du risque

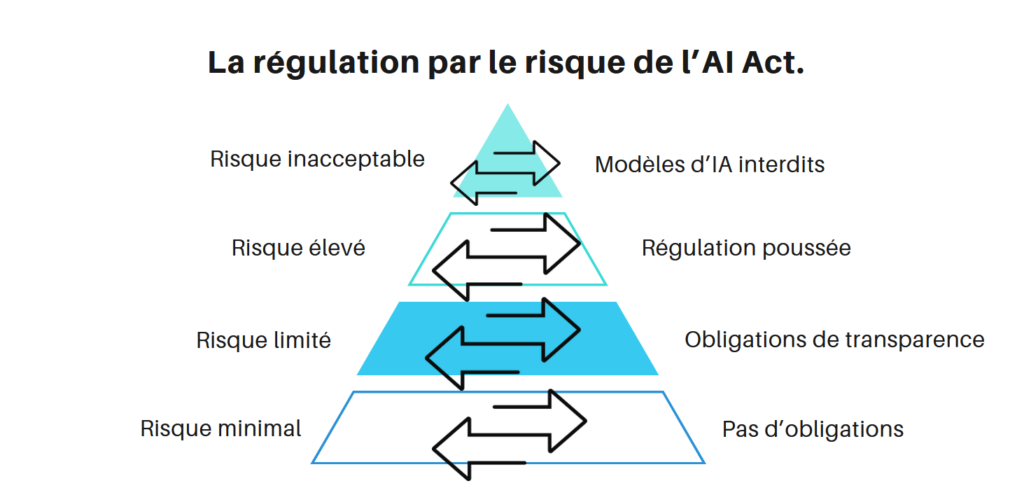

Pour trouver cet équilibre, le texte adopte une approche assez originale des problématiques liées aux intelligences artificielles : une réglementation en fonction du risque présenté par chaque modèle d’IA qui se divise en 4 catégories :

- Les IA à risque minimal : le texte vise ici des modèles assez basiques, tels que les filtres anti-spam ou encore les systèmes de recommandation. Considérant que ces systèmes représentent un risque moindre pour les droits et la sécurité des citoyens, le texte les exonère de toute obligation.

- Les IA à risque limité : les modèles ciblés ici sont ceux permettant la génération de contenus de type image, vidéos ou audio comme MidJourney, ou encore Dall-E, plus connues sous le nom d’intelligences artificielles génératives.

Dans le cadre de ces systèmes, la réglementation exige plus de transparence avec les utilisateurs (il doit être spécifié que le contenu a été généré par une IA, et les utilisateurs doivent être informés qu’ils utilisent cette technologie), mais vient également poser un cadre dans leur conception. Ces modèles doivent être conçus de manière à ce qu’ils ne puissent pas générer de contenu illégal (discriminatoire, à caractère pédopornographique ou encore violent) et les sociétés doivent publier des résumés des données protégées par le droit d’auteur qui ont été utilisées pour entraîner leurs systèmes.

- Les IA à risque élevé : cette catégorie s’attache aux intelligences artificielles pouvant représenter un risque pour les droits fondamentaux et la sécurité des citoyens. Deux systèmes sont visés en particulier :

D’une part, les IA utilisées dans les produits relevant de la directive 2001/95/Ce du Parlement européen et du conseil du 3 décembre 2001 relative à la sécurité globale des produits. Concrètement, l’AI Act vise les IA utilisées dans le domaine de l’aviation, de l’automobile, des dispositifs médicaux, ou encore des jouets.

D’autre part, les IA utilisées dans le cadre de la gestion de services primordiaux, notamment dans les secteurs de l’éducation et la formation professionnelle, de l’accès et la jouissance des services publics et privés essentiels, ou encore de la migration.

Au vu des risques qu’elles peuvent représenter, ces systèmes d’IA sont soumis à des règles plus strictes : Ils doivent être enregistrés dans une base de données de l’Union européenne, et sont soumis à une évaluation de conformité détaillé avant leur mise sur le marché, puis tout au long de leur existence.

- Les IA à risque inacceptable : cette catégorie vise les systèmes d’IA considérés comme menaçant directement les personnes et leurs droits fondamentaux.

On y retrouve notamment les modèles permettant la mise en place de systèmes de catégorisation biométrique qui utilisent des caractéristiques sensibles (les convictions politiques, religieuses, ou encore l’orientation sexuelle…), ceux permettant la manipulation du comportement humain, la reconnaissance des émotions sur le lieu de travail et dans les établissements d’enseignement, ou encore les systèmes de notation sociale.

L’ensemble de ces systèmes d’IA sont expressément interdits par le texte. Cependant, des exceptions sont possibles à des fins d’application de la loi. Par exemple, les systèmes d’identification biométriques à postériori peuvent être autorisés aux fins de poursuite de crimes graves et seulement après l’approbation du tribunal.

Des mesures spécifiques à l’innovation

Concernant l’innovation en elle-même, le texte propose également des mesures de soutiens directes, notamment aux articles 53, 54, et 55. On y retrouve deux éléments :

- La mise en place de “bacs à sable réglementaires” permettant concrètement aux acteurs du secteur de l’IA de bénéficier de l’accompagnement d’experts dans le domaine du juridique et de la technique. En France, la Commission Nationale de l’Informatique et des Libertés (CNIL) accompagne déjà plus de 8 projets innovants en matière d’intelligences artificielles afin d’assurer le développement d’IA respectueuses de la vie privée et plus largement du règlement sur la protection des données personnelles (RGPD).

- La mise en place de paquets d’innovation en matière d’IA pour soutenir les start-ups et les petites et moyennes entreprises (PME) en intelligence artificielle, dont les premières traces ont vu le jour le 24 janvier 2024.

SOURCES :

- Législation sur l’intelligence artificielle: le Conseil et le Parlement parviennent à un accord sur les premières règles au monde en matière d’IA.

- Citation d’Emmanuel Macron, durant l’annonce des nouveaux axes de développement pour le plan d’investissements France 2030.

- Rapport de la Quadrature du Net sur le système de notation de la Caisse d’Allocation Familiales (CAF)

- Citation de Thierry Breton, tirée de son passage à La Tribune du 10 décembre 2023

- Articles 53, 54, et 55 de l’AI Act

- Rapport de la CNIL du 22 novembre 2023 : « Bac à sable » intelligence artificielle et services publics : la CNIL accompagne 8 projets innovants

- Paquets d’innovation en matière d’IA pour soutenir les startups et les PME en intelligence artificielle

- Illustration réalisée à partir des modèles obtenus sous licence Canva Pro.