par Romane GRILLET, étudiante du Master 2 Droit des communications électroniques

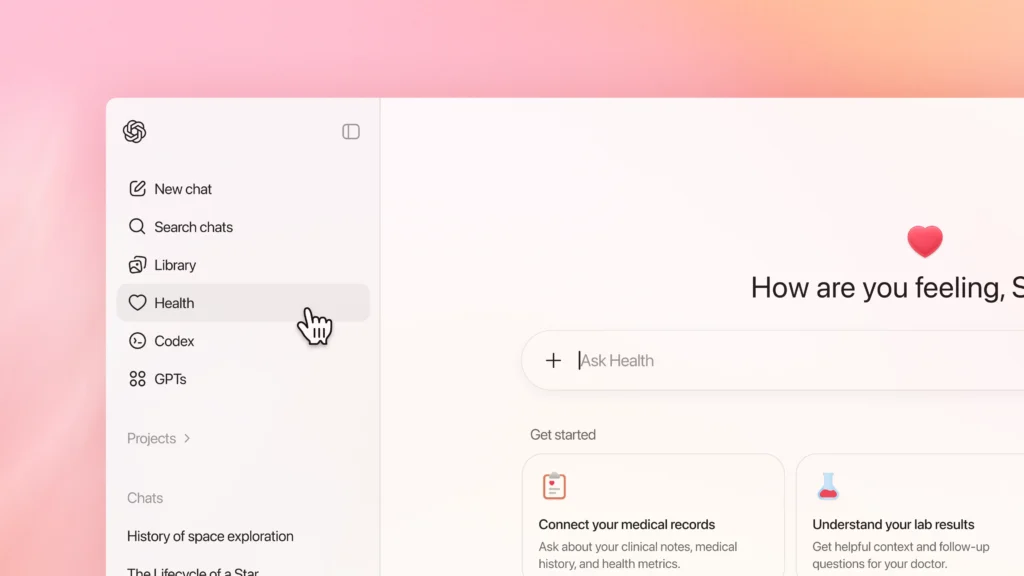

Le 7 janvier 2026 marque un tournant historique pour la santé numérique avec le lancement officiel, par OpenAI, de ChatGPT Santé. En connectant vos dossiers médicaux et vos applications comme Apple Santé ou encore MyFitnessPal, l’intelligence artificielle (IA) n’est plus un simple assistant de discussion, elle devient un véritable agent capable d’analyser vos données pour préparer vos rendez-vous médicaux ou à comprendre vos résultats d’analyse.

Cette innovation répond au constat massif selon lequel plus de 230 millions de requêtes de santé, physique et mentale sont générées sur la plateforme ChatGPT. Pour bâtir ce système, OpenAI a mobilisé plus de 260 médecins, répartis dans soixante pays, et a recueilli 600 000 retours d’expérience sur deux années. Pourtant, OpenAI joue sur les mots. D’un côté, l’entreprise vend une IA capable de lire vos antécédents médicaux et de donner des conseils médicaux, mais de l’autre, elle promet que son outil ne remplace pas un médecin et ne donne aucun diagnostic officiel. Cette stratégie de défense peine à convaincre l’Europe qui a choisi de bloquer l’innovation sur son territoire tandis que l’Amérique l’utilise déjà.

Ce blocage n’est pas un simple retard technique, mais démontre que l’Europe refuse de traiter la santé comme une marchandise. Entre la protection très stricte de nos informations privées et l’arrivée d’outils français comme Doctolib, qui propose des assistants hébergés en Europe, un fossé s’est creusé. En effet, ChatGPT Santé, entrainé sur le web entier et soumis aux lois américaines, se heurte à nos normes européennes, notamment sur la sécurité et la dignité humaine.

Dès lors une question centrale se pose : le cadre juridique européen est-il compatible avec cette innovation ou risque-t-il d’engendrer un retard technologique majeur face aux États-Unis en imposant des exigences quasi impossibles à satisfaire pour OpenAI ?

I. La divergence des modèles américain et européen : entre pragmatisme contractuel et conformité préalable

Aux États-Unis, le déploiement de ChatGPT Santé s’inscrit dans une logique de droit des contrats et de responsabilité a posteriori. Bien que la loi HIPAA (Health Insurance Portability and Accountability Act) encadre la confidentialité des données de santé. Le système, en tant que service direct au consommateur, repose largement sur le consentement de l’utilisateur, à travers les conditions générales d’utilisation (terms of service), et la responsabilité de l’opérateur en cas de faille. L’approche américaine favorise ici l’innovation avec une mise sur le marché rapide, dont l’algorithme s’affine par l’usage massif, en préférant réguler a posteriori.

À l’inverse, l’Union européenne a fait le choix d’une logique de régulation ex ante, dans laquelle la mise sur le marché est conditionnée par la preuve préalable de la conformité. Elle considère que certains domaines, dont celui de la santé, ne peuvent pas être laissés à la seule autonomie de la volonté ou au droit des contrats. Pour être autorisé sur le territoire de l’UE, ChatGPT Santé devra prouver qu’il respecte un certain cadre légal, notamment le RGPD pour les données, l’AI Act s’il est qualifié d’IA à haut risque ou encore le règlement sur les dispositifs médicaux (MDR).

Ce décalage entre les modèles américain et européen crée une asymétrie d’innovation préoccupante mais assumée. Tandis que les États-Unis bénéficient d’un terrain d’entrainement privilégié, grâce aux données réelles de millions de patients, l’Europe risque de subir un fort retard technologique. Cependant, à travers cette approche, l’Europe refuse que la santé devienne une marchandise en veillant à ce que l’innovation ne nuise pas aux droits fondamentaux.

II. L’arbitrage européen : la sécurité des données sensibles au prix d’un ralentissement de l’IA médicale

Le déploiement de ChatgGPT santé en Europe se heurte, dès sa conception, à la nature exceptionnelle des informations qu’il traite. Malgré les promesses techniques d’OpenAI sur la « sécurité renforcement » et des « chiffrements dédiés », le droit de l’Union offre une protection supérieure aux données numériques ordinaires pour les données de santé.

En vertu de l’article 9 du RGPD, ces données sont qualifiées de données personnelles sensibles et leur traitement est par principe interdit. Pour lever ce verrou juridique, ChatGPT Santé doit se soumettre à des exceptions strictement encadrées dont la mise en œuvre se heurte à des obstacles majeurs.

La première exception impose de recueillir le consentement explicite de l’utilisateur au sens de l’article 9.2 du RGPD, en plus des conditions prévues par l’article 4 dudit règlement, à savoir un consentement libre et éclairé. Or, dans un contexte médical, le consentement ne semble pas répondre à ces exigences. D’une part, la vulnérabilité du patient face à la nécessité médicale, plutôt qu’un choix réel, exclut toute liberté réelle et le manque de transparence du modèle rend impossible une information éclairée sur l’usage futur des données sensibles. D’ailleurs, ce manque de transparence pourrait rendre l’analyse d’impact relative à la protection des données (article 35 du RGPD) complexe, voire impossible.

La seconde difficulté concerne le risque majeur de détournement de finalité. L’article 5.1.b du RGPD impose que les données soient collectées dans un but précis et interdit donc que les données médicales puissent servir, même de façon anonymisée, à l’entrainement futur des modèles de langage sans un nouveau consentement.

Enfin, l’impératif de souveraineté, lié à leur stockage, bloque le projet. En France, le code de la santé publique exige une certification HDS (hébergeur de données de santé) garantissant une sécurité et une traçabilité que l’infrastructure d’OpenAI, centralisée aux États-Unis, ne peut offrir. En effet, en restant soumise au Cloud Act américain, les autorités américaines sont autorisées à accéder aux serveurs même à distance. Or, depuis l’arrêt Schrems II de la CJUE, le transfert de données sensible vers un pays qui n’offre pas les mêmes garanties de protection que l’UE est illicite. Ainsi, sans serveurs basés en Europe et totalement isolés des États-Unis, les promesses de confidentialité semblent être mensongères.

III. Une IA à « haut risque » ? Un défi opérationnel pour le règlement européen IA Act

Au-delà du caractère « sensible » des données, c’est la nature même du système qui interroge au regard de l’IA Act. Bien qu’il s’agisse d’une IA à usage général, sa spécialisation médicale pourrait entrainer sa requalification en système d’IA à haut risque au sens de l’article 6 dudit règlement. La dangerosité d’un système ne s’évalue pas seulement par sa technologie, mais par son impact potentiel sur la vie humaine. Ainsi, dès lors qu’un outil influe sur des décisions relatives à la santé ou à la sécurité des personnes, en s’invitant dans le parcours de soin, une erreur de l’algorithme, telle qu’une omission de diagnostic ou une recommandation de traitement erronée, constitue une menace directe pour l’intégrité des personnes, dépassant le simple défaut de service.

La qualification d’IA à haut risque déclenche alors l’application d’un régime de régulation renforcée à travers des exigences de qualité bien plus strictes avant toute mise sur le marché. Cela implique notamment la mise en place d’un système de gestion des risques sur tout le cycle de vie du système, une gouvernance des données irréprochable (article 10 AI Act) mais quasi impossible à réaliser car ChatGPT a été entrainé sur le web entier ou encore l’établissement d’une documentation technique tellement détaillée qu’elle revient à exposer l’architecture intime de l’algorithme, contrainte que les entreprises technologiques refusent généralement pour protéger leur avantage concurrentiel mais qui est obligatoire en matière de santé (article 11 AI Act).

Face à ces exigences, OpenAI tente de contourner cette difficulté en précisant que l’IA « vient en soutien et non en remplacement » du professionnel de santé. Or, le droit européen privilégie une approche fonctionnelle, c’est-à-dire que si l’outil est capable d’analyser des données biologiques ou d’interpréter des symptômes pour suggérer une conduite à tenir, il remplit une fonction de diagnostic de fait. Cette analyse s’appuie sur l’arrêt Snitem de la CJUE de 2017, selon lequel un logiciel est un dispositif médical dès lors qu’il exploite des données brutes en conseils personnalisés, En transformant des données brutes en conseils personnalisés, Chatgpt Santé sort ainsi du cadre de la simple information pour entrer dans celui de la santé réglementée.

L’enjeu est donc crucial ici, l’exigence de sécurité juridique ne doit pas aboutir à une prudence paralysante mais elle garantit que l’innovation médicale ne se fasse pas au prix d’une opacité algorithmique dangereuse pour l’utilisateur.

Sources :

- Article 9 du RGPD

- Article 4 du RGPD

- Article 5 du RGPD

- Article 35 du RGPD

- Article 5 du RGPD

- CJUE, n°C‑311/18, Arrêt de la Cour, Data Protection Commissioner contre Facebook Ireland Lt et Maximillian Schrems, 16 juillet 2020

- Code de la santé publique

- Article 6 AI Act

- Article 10 AI Act

- Article 11 AI Act

- CJUE, n° C-329/16, Arrêt de la Cour, Syndicat national de l’industrie des technologies médicales (Snitem) et Philips France contre Premier ministre et ministre des Affaires sociales et de la Santé, 7 décembre 2017

- Clarifying Lawful Overseas Use of Data Act 2018

- Règlement (UE) 2017/745 du Parlement européen et du Conseil du 5 avril 2017 relatif aux dispositifs médicaux

- https://www.lesnumeriques.com/intelligence-artificielle/openai-lance-chatgpt-sante-faut-il-confier-son-corps-a-une-ia-formee-par-260-medecins-n249320.html